categoria: Distruzione creativa

Intelligenza artificiale, l’Europa delle regole scenda anche in campo

Post di Antonio Lanotte, Of Counsel Deotto Lovecchio & Partners –

Il 13 marzo scorso il Parlamento europeo ha votato per l’approvazione del primo quadro giuridico completo al mondo per la regolamentazione dell’intelligenza artificiale: Artificial Intelligence Act (la “legge sull’intelligenza artificiale”). Il crescente utilizzo di strumenti di AI e la diffusione e l’ampio uso di generative AI come “ChatGPT” hanno sollevato preoccupazioni sulle loro implicazioni etiche, legali e sociali. In questo contesto, il nuovo regolamento europeo mira a regolamentare la progettazione e l’utilizzo dell’intelligenza artificiale.

Il suo obiettivo è rafforzare la fiducia nell’AI, controllare il suo impatto sulla società, sulle imprese e sugli individui (e in particolare sui diritti fondamentali di questi ultimi), creando al contempo un contesto favorevole alla ricerca e allo sviluppo, all’economia e all’innovazione. Oggi solo il 3% degli unicorni mondiali dell’AI proviene dall’UE, mentre gli investimenti privati nell’AI sono 14 volte superiori negli Stati Uniti e 5 volte superiori in Cina. Entro il 2030, si prevede che il mercato globale dell’AI raggiungerà i 1.500 miliardi di dollari, ed è pertanto necessario che le aziende europee vi accedano senza rimanere invischiate nella burocrazia. Alla luce di ciò, l’Unione Europea ha agito da pioniere sviluppando il primo regolamento al mondo sull’AI.

Che cosa prevede l’Artificial Intelligence Act

Il testo, nella sua versione iniziale proposta dalla Commissione europea nel 2021, rispondeva alla crescita della tecnologia dell’intelligenza artificiale a partire dagli anni 2010 e si è evoluto in risposta allo sviluppo dell’AI generativa. La versione consolidata attualmente disponibile dovrebbe consentire agli attori dell’intelligenza artificiale di anticipare quali saranno le principali problematiche legate all’applicazione dell’AI Act e di iniziare a implementare questa normativa nella loro strategia di compliance.

In estrema sintesi:

– Un quadro normativo per l’intelligenza artificiale;

– Un approccio coerente basato sul rischio, volto a stabilire se un sistema di intelligenza artificiale possa essere legittimamente sviluppato e utilizzato attraverso una scala progressiva di rischi per i diritti fondamentali;

– Una definizione armonizzata a livello europeo dei concetti chiave (in particolare le definizioni dei principali sistemi di intelligenza artificiale);

– Una serie di obblighi rafforzati per gli attori dell’intelligenza artificiale;

– Una struttura di governance europea con autorità dedicate;

– Una serie di sanzioni per la non conformità al regolamento; e

– Un’agenda chiara e dettagliata per l’entrata in vigore e l’applicazione dell’AI Act.

(noah9000 – stock.adobe.com)

Alcuni punti salienti del AI Act

– Il regolamento definisce la nozione di sistema di intelligenza artificiale (“AIS” o “AI System”) per distinguere gli AIS dai sistemi software più semplice;

– L’Unione Europea mira a creare un quadro globale e sicuro per l’intelligenza artificiale e, con questo obiettivo in mente, intende rivolgersi a un’ampia gamma di attori (tutti gli utilizzatori, i distributori, gli importatori, i produttori e i fornitori di sistemi di AI che hanno un legame con l’UE).

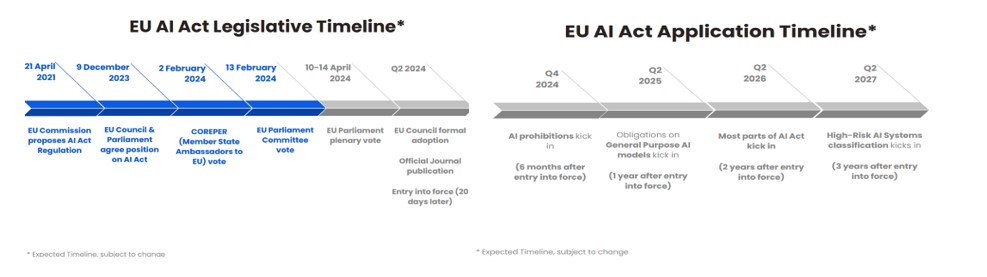

Dall’approvazione in seduta plenaria alla sua implementazione

A questo punto l’AI Act dovrà essere rivisto prima di essere approvato dal Consiglio dell’Unione europea e quindi adottato definitivamente. Una volta adottato formalmente e pubblicato nella Gazzetta ufficiale dell’Unione europea, entrerà in vigore venti giorni dopo la sua pubblicazione. Una volta promulgata la legge sull’AI, i suoi requisiti e obblighi finali entreranno in vigore per fasi. L’attuazione avverrà gradualmente (sarà pienamente applicata trentasei (36) mesi dopo la sua entrata in vigore) secondo le seguenti fasi:

- 1. sei (6) mesi per conformarsi alle norme sui sistemi di AI vietati;

- 2. dodici (12) mesi per implementare la conformità ai requisiti GPAI (Global Partnership on Artificial Intelligence);

- 3. ventiquattro (24) mesi per implementare la conformità globale con i sistemi di AI;

- 4. trentasei (36) mesi per conformarsi alle norme sui sistemi di AI ad alto rischio.

Compliance e aspetti sanzionatori

In termini di applicazione territoriale, questo regolamento è in linea con i principali regolamenti di conformità creati dall’Unione Europea negli ultimi due decenni; quindi, come il Regolamento generale sulla protezione dei dati (“GDPR”), è di applicazione extraterritoriale. Avrà una portata globale e, quindi, creerà nuovi obblighi per le organizzazioni di tutti i settori e lungo tutta la catena di fornitura che commercializzano e utilizzano sistemi di AI nell’Unione Europea. Lo scorso 24 gennaio 2024, la Commissione europea ha designato un Ufficio europeo per l’intelligenza artificiale. Il suo ruolo è quello di sostenere e garantire la corretta attuazione della legge sull’AI. Procedendo in questo modo, l’UE ha voluto garantire un’attuazione coordinata a livello europeo del futuro regolamento.

I compiti di questo ufficio comprendono:

- 1. contribuire a un approccio strategico, coerente ed efficace dell’Unione europea alle iniziative internazionali sull’AI, in coordinamento con gli Stati membri e in linea con le posizioni e le politiche dell’Unione europea;

- 2. cooperare con tutti gli organi, gli uffici e le agenzie competenti dell’Unione europea;

- 3. cooperare con le autorità e gli organi degli Stati membri a nome della Commissione europea.

Sotto l’aspetto sanzionatorio l’Unione Europea ha dimostrato la sua volontà politica di dotarsi dei mezzi per far rispettare la legge sull’AI:

Le sanzioni più gravi in caso di inadempienza ammontano a:

– 35 milioni di euro;

oppure

– il 7% del fatturato mondiale totale annuo dell’esercizio precedente per le persone giuridiche, se superiore.

Le PMI e le start-up beneficiano di un regime sanzionatorio modificato, per il quale ciascuna sanzione di cui all’articolo 71 (“Sanzioni”) è pari alla percentuale o all’importo più basso indicato in caso di opzione.

Alcune considerazioni sull’ AI Act

L’AI Act pone restrizioni ai casi di utilizzo dell’intelligenza artificiale che comportano un rischio elevato per i diritti fondamentali delle persone, come l’assistenza sanitaria e l’istruzione ad esempio. Sono inoltre vietati alcuni usi che si ritiene rappresentino un “rischio inaccettabile”. Si tratta di casi d’uso piuttosto strani e ambigui, come i sistemi di AI che impiegano “tecniche subliminali, manipolative o ingannevoli per distorcere il comportamento e compromettere il processo decisionale informato” o sfruttano persone vulnerabili.

L’ AI Act vieta anche i sistemi che deducono caratteristiche sensibili come le opinioni politiche o l’orientamento sessuale di una persona e l’uso di software di riconoscimento facciale in tempo reale nei luoghi pubblici. Sarà vietata anche la creazione di database di riconoscimento facciale attraverso lo scraping di Internet (letteralmente raschiare informazioni), come nel caso di Clearview AI.

Tuttavia, da adesso in poi sarà più evidente quando si interagisce con un sistema di AI, infatti:

- 1. Le aziende tecnologiche dovranno etichettare i cd deepfake e i contenuti generati dall’AI e avvisare le persone quando interagiscono con una chatbot o un altro sistema di AI. Inoltra, l’AI Act richiederà a quelle società che sviluppano media utilizzando AI generativa di renderne possibile l’individuazione. In altri termini, si tratta di una notizia promettente nella lotta alla disinformazione e darà un forte impulso alla ricerca sul watermarking e sulla provenienza dei contenuti.

- 2. I cittadini potranno presentare reclami se sono stati danneggiati dall’utilizzo dell’AI. Difatti, il Regolamento prevede l’istituzione di un nuovo Ufficio europeo per coordinare la conformità, l’attuazione e l’applicazione. A tal proposito, i cittadini dell’UE potranno presentare reclami sui sistemi di AI quando sospettano di essere stati danneggiati da uno di essi e potranno ricevere le dovute spiegazioni. Si tratta, senza dubbio, di un primo passo importante per dare alle persone più potere in un mondo sempre più automatizzato.

- 3. Le aziende di AI dovranno essere più trasparenti. Le aziende che sviluppano tecnologie di AI in settori cd “ad alto rischio”, come le infrastrutture critiche o l’assistenza sanitaria o anche l’istruzione, avranno nuovi obblighi sempre più stringenti quando la legge entrerà pienamente in vigore tra tre anni (36 mesi). Questi includono una migliore governance dei dati, la garanzia di una supervisione umana e la valutazione di come questi sistemi influenzeranno i diritti delle persone.

Intelligenza artificiale e regole europee, le 8 azioni utili per le aziende

L’effetto potenziale dell’ AI generativa sulla produttività è notevole, con la possibilità di contribuire per trilioni di dollari all’economia globale. Le ricerche indicano che l’AI generativa è in grado di generare un valore annuo equivalente a un valore compreso tra 2,6 e 4,4 trilioni di dollari nei 63 casi d’uso esaminati. Per mettere questo dato in prospettiva, l’intero PIL del Regno Unito nel 2021 era di 3,1 trilioni di dollari. Pertanto, l’aggiunta del valore dell’AI generativa potrebbe aumentare l’effetto complessivo dell’AI sul PIL del 15-40%[1].

Con l’entrata in vigore dell’AI Act occorrerà pertanto mettere in piedi una serie di azioni utili alla compliance e alla massima trasparenza e che possono essere qui riepilogati:

1. Mappare i sistemi già utilizzati che potrebbero essere considerati sistemi di intelligenza artificiale. La definizione di sistemi di intelligenza artificiale è molto ampia e non include solo i sistemi di intelligenza artificiale di uso generale. È necessario eseguire una due diligence interna per qualificarli correttamente.

2. Includere nei contratti con i fornitori l’obbligo di rispettare la legge sull’intelligenza artificiale (AI) è una pratica prudente per garantire la conformità legale e l’etica nelle operazioni aziendali. Per quanto riguarda i contratti esistenti, potrebbe essere necessario avviare una fase di rinegoziazione per includere queste clausole o aggiornare i termini contrattuali esistenti in base alle normative sull’AI. Questo potrebbe richiedere una collaborazione stretta con i fornitori e, in alcuni casi, potrebbe essere necessario coinvolgere anche consulenti legali specializzati in diritto dell’intelligenza artificiale o tecnologie emergenti.

3. L’inclusione di clausole contrattuali che richiedono il rispetto delle leggi sull’AI è sicuramente un passo importante per garantire la conformità e mitigare i rischi legali e etici. Tuttavia, è altrettanto importante considerare la necessità di flessibilità e adattabilità nel caso in cui si verifichino cambiamenti significativi nelle normative, nei requisiti operativi o nelle condizioni di mercato che potrebbero influenzare l’implementazione e il funzionamento dei sistemi AI.

In definitiva, è importante trovare un equilibrio tra la necessità di conformità legale e la necessità di flessibilità operativa nell’implementazione e nella gestione dei sistemi di intelligenza artificiale. Un approccio collaborativo e flessibile tra le parti contrattuali può contribuire a garantire che gli investimenti in AI siano protetti e che l’azienda possa adattarsi in modo efficace ai cambiamenti nel panorama normativo e operativo.

4. Adottare politiche tecniche e operative interne per regolare l’uso dell’AI è fondamentale per garantire la conformità legale, gestire i rischi e promuovere un utilizzo etico e responsabile di tali tecnologie all’interno dell’azienda. La legge europea sull’AI introduce diverse categorie di sistemi di AI, ciascuna con obblighi specifici, quindi è essenziale che le aziende sviluppino politiche interne adatte alle proprie esigenze e alle caratteristiche dei sistemi utilizzati.

In sintesi, sviluppare e implementare una robusta governance interna sull’AI è cruciale per gestire i rischi e massimizzare i benefici derivanti dall’adozione di queste tecnologie all’interno dell’azienda. Una governance efficace richiede un approccio olistico che coinvolga diverse funzioni aziendali e tenga conto delle normative e delle migliori pratiche in materia di AI.

5. È assolutamente cruciale per le aziende implementare soluzioni per garantire la conformità alle normative sulla privacy e sulla proprietà intellettuale quando si utilizzano sistemi di intelligenza artificiale (AI). Questo è particolarmente importante considerando le implicazioni legali e le potenziali conseguenze di non conformità, come multe, sanzioni e danni reputazionali. L’implementazione di soluzioni per garantire la conformità alle normative sulla privacy e sulla proprietà intellettuale è essenziale per mitigare i rischi legali e proteggere la reputazione dell’azienda nell’utilizzo dei sistemi di intelligenza artificiale[2].

6. Adottare uno strumento specifico per la conformità all’AI Act è fondamentale per garantire che le politiche e le procedure interne siano effettivamente implementate e rispettate nell’utilizzo dei sistemi di intelligenza artificiale (AI). Questi strumenti possono aiutare le aziende a valutare in modo sistematico e dettagliato la conformità con le disposizioni dell’AI Act e altre normative pertinenti, nonché a identificare e mitigare i rischi associati all’uso dei sistemi di AI.

Adottare uno strumento di conformità all’AI Act è essenziale per tradurre le politiche e le procedure interne in azioni concrete e misurabili (KPIs) per garantire la conformità legale e etica nell’utilizzo dei sistemi di intelligenza artificiale. Assicurarsi che lo strumento sia adeguatamente personalizzato, utilizzato in modo efficace e integrato nell’approccio complessivo alla governance dell’AI dell’azienda.

7. Proteggere i segreti commerciali interni e le informazioni riservate è fondamentale per preservare la competitività dell’azienda e mantenere la fiducia dei clienti e dei partner commerciali. Data la natura sensibile delle informazioni coinvolte e il rischio di divulgazione non autorizzata, è essenziale implementare misure tecniche e organizzative robuste per prevenire abusi da parte dei dipendenti e garantire la sicurezza delle informazioni.

A tal proposito, proteggere i segreti commerciali interni e le informazioni riservate richiede un approccio olistico che combini misure tecniche e organizzative per prevenire abusi da parte dei dipendenti e garantire la sicurezza delle informazioni sensibili dell’azienda. La collaborazione tra diversi dipartimenti e l’adozione di politiche e procedure chiare sono fondamentali per garantire un efficace programma di compliance e sicurezza delle informazioni.

8. Infine, la formazione dei dipendenti è un elemento fondamentale per promuovere una cultura di conformità all’AI all’interno dell’azienda. Investire nella formazione interna può aiutare a creare una base solida di conoscenze e competenze necessarie per guidare con successo l’implementazione e l’uso responsabile dei sistemi di intelligenza artificiale.

Sviluppo etico e responsabile ma l’Europa scenda in campo

In conclusione, il Regolamento sull’AI rappresenta una pietra miliare e riflette l’impegno dell’UE a promuovere uno sviluppo etico e responsabile dell’AI. Affrontando sfide fondamentali come la trasparenza, la responsabilità e la gestione del rischio, mira a sfruttare il potenziale dell’AI salvaguardando i diritti e i valori fondamentali. Tuttavia è bene sottolineare come aver dotato il Mercato Unico Europeo di un Regolamento di questo genere, non deve frenare le nostre aziende dall’investire risorse in questo campo per uno sviluppo ulteriore e soprattutto per non perdere il passo con Stati Uniti d’America e Cina che, invece, stanno correndo in questo campo. In sintesi si riprenda una curiosa frase del tipo: “The USA Innovates, China Replicates and Europe Regulates”.

Si potrebbe pensare che l’Europa non sia un grado di competere con USA e Cina in materia di AI, e che per questo magari che si è deciso di normare, giocando di anticipo, per arginare eventuali usi e abusi di AI. In sostanza si gioca in difesa. Si è del parere tuttavia che questo approccio sia assolutamente sbagliato. Piuttosto l’Europa è in grado di competere con USA e Cina purché decida di smettere di essere l’arbitro e di schierare la sua squadra in campo.

La continua evoluzione della tecnologia, il dialogo costante e la collaborazione tra le parti interessate (stakeholders) saranno essenziali per garantire che i quadri normativi possano essere efficaci, come anche lo spirito di iniziativa nel plasmare il futuro dell’AI non arrecando alcun gap di carattere tecnologico che, considerando il settore in discussione, potrebbe avere delle forti ripercussioni anche di carattere geo-politico.

NOTE

[1] (Antonio Lanotte, TNI, “From Artificial to Circular Intelligence: The Role of Generative AI”)

[2] (Antonio Lanotte, Centro Studi Deotto Lovecchio & Partners, “Tax Control Framework (Tcf) e Enterprise Risk Management (Erm): opportunità e vantaggi”)